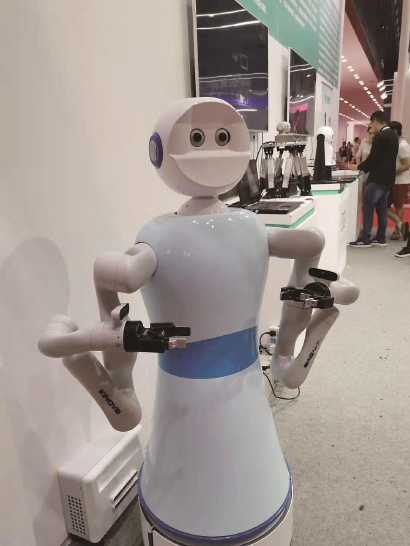

▲ 第一代仿生视觉机器人“小白”(中国科学院上海微系统与信息技术研究所仿生视觉系统实验室供图)

“小白,小白!”记者叫了一声机器人的名字,一双机器“眼睛”立刻转了过来。接下来,记者走到哪里,它的“视线”就追到哪里,记者跟展台解说员交谈,它也随着话音变化,时而“注视”记者,时而“看”着解说员。在2019世界人工智能大会“类脑智能与群智智能主题论坛”分会场,这台“明眸善睐”的机器人将和与会者用眼神密切交流。

放眼全球,如此接近人类的机器人“眼睛”可谓举世无双,而指挥“明眸”的是一套名为“机器头脑”的系统。作为去年启动的上海市级科技重大专项“脑与类脑智能基础应用转化研究”的重点研究内容之一,“机器头脑”将于2023年完成,届时,它将发展成为一个包含多模态信息感知、分析与决策功能在内的类脑系统多学科功能平台。此次亮相2019世界人工智能大会的“小白”,是融合了视觉、听觉、平衡功能的第一代设备。

“目前,类脑智能普遍代表对大脑的模拟,但人类的脑系统实际上包含大脑、小脑、丘脑、脑干等,一般的研究者往往忽略了其完整性。”专项主要负责人之一、中国科学院上海微系统与信息技术研究所仿生视觉系统实验室主任张晓林介绍,“机器头脑”想通过模仿人的脑系统,推进类脑人工智能的发展。

“小白”究竟有哪些非同寻常的本领?

“目前,国内外像我们一样由仿生视觉开展类脑智能研究的团队几乎没有。”张晓林说,通过模仿人类视觉系统的“小白”能在有人对它挥手时及时捕捉到挥手人的身影;能在颠簸的车辆上“看清”图像;还能在几位交谈者说话时,跟随声音切换视线。

这些视觉动作看似极其寻常,但让机器实现起来并不容易。张晓林认为,对于人脑的仿生,将伴随人工智能的发展,尽管现在还无法清楚了解其中的机理,但仅通过模仿,用工程来实现这些功能,已获得了相当大的发展。比如,颠簸中捕捉稳定的图像,模仿的就是人耳中的器官“前庭”,团队用惯性传感装置让人工视觉具有了“前庭动眼反射”的功能。

张晓林认为,这只是初级阶段,未来还需将听觉、触觉、嗅觉,甚至语义理解等与视觉相融合,才算实现真正的类脑人工智能。比如对机器人说:“走到桌子前!”这就需要机器人将“桌子”这个读音转换为词语,并解析出“桌子”的概念,然后在四周获取的图像中找出符合的物体,再判断出哪个位置符合命令,最后执行指令。为此,张晓林提出机器“意识空间”的概念,即在机器人的“意识”中,应该存在现实世界的映射,机器也能拥有空间想象能力。

目前,该项目已研发出了包括高精度三维重建、视觉里程计、目标检测与跟踪、语义分割等类脑核心算法,为构建机器“意识空间”奠定了基础。这将为危险监测、高铁轨旁监测等应用场景,提供更先进可靠的技术手段。

作者:许琦敏

编辑:沈湫莎 陈曦(实习生)

责任编辑:樊丽萍

*文汇独家稿件,转载请注明出处。