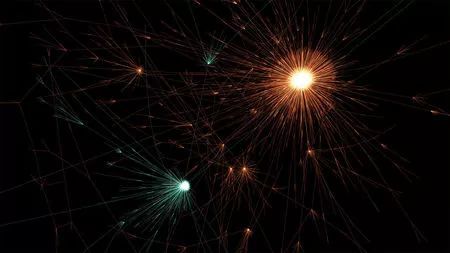

▲在Twitter中,含有假消息的推文(在此数据可视化中用橙色表示)比含真实新闻的推文传播面更大

在2018年3月9日出版的最新一期《科学》杂志上,麻省理工学院的三位研究者发表了一则迄今为止最大规模、最系统性的假新闻传播研究。他们分析了过去12年间的12.6万则新闻在推特上的传播情况,结果发现:假新闻跑得比真新闻更快、更深、更广,而跑得最快的假新闻类型则是政治新闻。

从俄国“bots(搜索引擎抓取机器人)”到传播假新闻的指控,新闻头条中充斥着各种病毒式传播的可疑信息。你可能认为传播这些网络信息是bot的错(或者说是自动化系统的错)。但是研究表明,人类才是通过社交网络传播错误信息的罪魁祸首,而非机器。

而人们对此也很拿手:该研究显示,含有虚假内容的推文在Twitter上传播给1500人的速度比内容真实的推文要快六倍。

在《科学》杂志发表的这则研究之前,还没有哪一则研究对这个问题进行过大规模、系统性的分析。

真相几乎没鞋穿

本新研究的灵感来源于2013年波士顿发生马拉松爆炸事件。麻省理工学院数据科学家、本研究第一作者Soroush Vosoughi说,攻击事件发生后,社交媒体上的很多内容都是错误的。有传言称,布朗大学的一名失踪的学生遭到警方怀疑。但后来,人们发现他与袭击无关,并且已经自杀身亡(原因与爆炸无关)。

当时,Vosoughi意识到“这些传闻不仅仅是Twitter上的玩笑话。它们确实可以对人们的生活造成影响,并且真的会对人们构成严重伤害。”那时,还是一名博士生的他决定将研究重点转移到检测和描述社交媒体信息的错误传播问题上。

他和他的同事收集了自2006年该社交媒体平台创办以来12年的数据。然后,提取了与PolitiFact、Snopes和FactCheck.org等六家独立核实组织已调查的新闻相关的推文。

最终得到了一组共含有12.6万条新闻(被300万人分享了450万次)的数据(这些消息有真有假,因此可以比较真新闻和假新闻的传播力),这些内容在同样的平台上竞争。那么,最终获胜的是谁呢?

研究者在四个维度上进行了对比:

首先是深度,也即被转发的“层级”。比如B转发了A,C又转发了B,那么深度就是3。假新闻的传播深度超过真新闻,最深可以超过19层,而真新闻的传播则基本不会超过10层。

其次是人数,也即参与转发的帐号数量。真新闻很少能被超过1000人转发,但排名前1%的假新闻却可以传播给一千到十万人。从时间上来看,要传播到1500个人,真新闻需要花的时间是假新闻的6倍之多。

第三是宽度,也即在任意一个层级上参与转发的最多人数。同样,传播力最强的真新闻,传播宽度只能刚刚超过1000,而假新闻则最多能达到好几万。

第四是结构性的病毒式传播力,这是研究者计算出来的一个数值,在这方面同样是假新闻更强。

从中,他们发现,真实新闻所覆盖的Twitter用户很少过千,而有害的假新闻(如梅威瑟的所谓抗议)的受众往往在一万以上。假新闻,尤其是政治方面的新闻,通过各种渠道传播得越来越快、越来越广。

都说“当真相还在穿鞋,谣言已经走遍天下”,这样看来,真相几乎没鞋穿。

为什么假新闻跑这么快?

在揭示“假新闻传播力强”这个事实之外,研究者尝试分析背后的原因。

会不会是因为传播假新闻的推特帐号粉丝更多、更有影响力?他们分析发现:恰恰相反,传播假新闻的帐号粉丝更少、更不活跃、更少被认证。也就是说,虽然这些帐号本身影响力不强,但假新闻却可以通过他们获得极强的传播力。

人类要对假新闻的病毒式传播负责

会不会是因为机器人帮助了假新闻的传播?的确,推特上有很多机器人帐号,自动转发假新闻内容。研究者通过一套算法识别出机器人帐号后,将这些帐号排除在外,重新进行分析,但结果保持不变。也就是说,不管有没有机器人,假新闻都跑得更快。

看来不能从传播假新闻的帐号和传播的网络结构上找原因,还是应该分析假新闻本身。研究者发现,被人们转发的假新闻有一个明显的特质:新鲜。他们用自然语言处理的方法,测量了一个推特帐号在发布假新闻之前60天读到的推文和假新闻之间的“信息距离”。用大白话说,这些推文之间越“八竿子打不着”,信息距离就越大。数据显示:比起真新闻而言,假新闻确实是和转发者之前读到的信息距离更远的,也就是更为新鲜的。

除此之外,他们还研究了假新闻和真新闻引发的情绪反应。他们用一套最新的情感分析词库,测量了对这些新闻的回复。结果发现,人们对假新闻的常见情绪反应是:惊奇、恶心、害怕,而对真新闻的常见反应是:期望、悲伤、快乐和信任。

“如果某件事听起来很疯狂或是很愚蠢,那么你可能认为它并不抓人眼球”,加州帕萨迪纳Snopes的事实调查记者Alex Kasprak说,“但是,它却能像大规模病毒一样传播。”

如何狙击假新闻

既然假新闻天生比真新闻更有传播力,那就意味着,需要有干预的方式,去限制假新闻的传播,促进真新闻的传播。

《科学》杂志的文章中提出了两种思路。第一种思路是提高个体辨识新闻真假的能力,包括提供更多的事实核查信息,以及进行媒介素养、批判思维方面的教育。作者认为,这两方面的工作固然重要,但是也都有局限性。

对于事实核查,有研究表明,因为人在认知上存在偏见——更容易选择和接受自己已经相信的东西,所以对于事实核查的接受程度会比较有限。也就是说,就算把真相摆在很多人面前,他们也不会选择相信。

对于教育项目,作者担心:会不会让人们对正规机构媒体的信任程度也下降?当然,因为这是更长期的事情,目前还没有对其效果进行评估的研究。作者呼吁,应该尽快对这样的项目效果进行科学的评估。

第二种思路是在社交媒体平台的层面进行干预,主要的干预方式是通过算法。目前,几乎所有的社交媒体平台都根据算法来呈现和排列信息。比如你在微博时间线上看到的内容,并不是按照时间顺序排列的,而是微博公司根据一定的规则自动为你过滤和排列的,这种规则就是算法。

《科学》杂志的作者指出:应该调整算法,给予真实、高质量的信息更多的权重,也就是让它们更频繁地出现在更显眼的位置上,而让那些错误、低质的信息出现在更不显眼的位置上。

实际上,一些社交媒体已经这样做了。去年,Facebook宣布调整算法,重视优质内容。然而问题是:外界很难评估这种改变是否有效,因为平台往往将算法的细节视为商业机密,也不愿意将数据向学界开放。

研究者认为,这些平台在商业利益之外,还应承担道德责任和社会责任,向研究者开放更多的数据和技术细节,以便评估其算法对社会产生的影响。

他们还认为,社交媒体平台彻底改变了我们的信息生态系统,我们需要更好的公共政策来干预和引导这样的生态系统,让它更少被假新闻污染。干预并不意味着进行审查,而是要基于坚实的实证依据,对平台产生的影响进行科学的评估,然后制定相关政策。

也就是说,要让真新闻跑得比假新闻快,当然需要提高每一位读者的素养,但更需要社交媒体平台承担更多的责任,需要学界更好的研究,也需要政策制定者科学、审慎的态度。

编辑制作:顾军

责任编辑:姜澎

*综合自搜狐科技、知识分子、环球网等