美国时间 2018 年4月4日,根据纽约时报报道,有 3100 名的谷歌员工联名发出公开信,向谷歌 CEO Sundar Pichai 进言,要求让谷歌退出由美国国防部 Maven 计划(Project Maven),在这封由谷歌员工联名的信中,一开始就明确提及,谷歌不应该参与任何与战争有关的生意,而谷歌不但应该要立刻退出Maven 计划,Sundar Pichai 更应该公开向所有人承诺,谷歌永远不会参与打造任何类型的战争科技。

但到目前为止,谷歌除了由发言体系出面说明谷歌所参与的 Maven计划部份内容外,仍未明确说明是否退出、或将采取何种作为,以因应目前已有 3100 名员工连名抗议的状况。

而就在同一时间,在亚洲也发生了同样AI学术研究界群起抵制不当用途的AI技术开发研究的运动。根据The Verge报导,全球超过50 名的人工智能与机器人科学家与研究人员共同宣布抵制与韩国科学技术院大学(KAISTUniversity)合作,这其中包括多位AI学术大神,Geoffrey Hinton、Yoshua Bengio、Jürgen Schmidhuber,此一抵制行动将无限期持续,直到KAIST大学保证其开发的武器将具有“真正意义上的人类控制”。

▲美国国防部办公大楼

对于 AI 善恶的讨论虽然已经很多,但到目前为止,却仍是各说各话的居多,大部份人都认为,人类必须要能够控制AI技术的演进发展,而不能放任到无法控制的地步。但也有人认为,AI为恶的可怕之处,不在于由AI自行演化所造成的失去控制,而在于有心作恶的人通过以 AI作为工具,进而造成一发不可收拾的科技灾难。

而以谷歌参与美国国防部Maven计划、以及韩国KAIST的杀手机器人开发计划来看,其实就正游走为善与作恶的灰色地带边缘。

之所以有3100名的谷歌员工联署发信要求退出Maven计划,就是因为这些谷歌人看到了危险的讯号,尽管公司先前已经说明Maven计划的性质属于针对无人机拍摄视频进行分析,并非用于战争武器的技术开发,但对于反对公司参与美国国防部 Maven计划的谷歌员工而言,这些说明都只是官样文章的多余。

对于拥有一个举世皆知座右铭 “ Don’t Be Evil ”的公司而言,在众多的谷歌天才员工中,有许多之所以选择加入,并不只是因为待遇,而更多的是信仰与理念。也因此,在上书给 Sundar Pichai 的员工联名信中就特别强调: “(Maven)这个计划将对谷歌品牌造成严重的伤害,也会令人才对加入谷歌公司观望却步,世界上已经有很多人对AI存有偏见,也抱持着高度的戒心,特别是如果AI技术被拿来用于武器开发上,这无疑会让AI受到更严重的质疑。”

至于引发全球多位AI学者与研究人员共同抵制合作的韩国KAIST大学计划,则是由新南威尔士大学教授Toby Walsh 发起,在发起抵制运动的公开信中,Toby Walsh 就提到:“如果开发出来,自主武器将使战争更快速地蔓延,规模比以往更大。”而这个潘多拉盒子一旦被打开,就将很难关闭。

到底谁在尝试打开潘多拉的盒子?

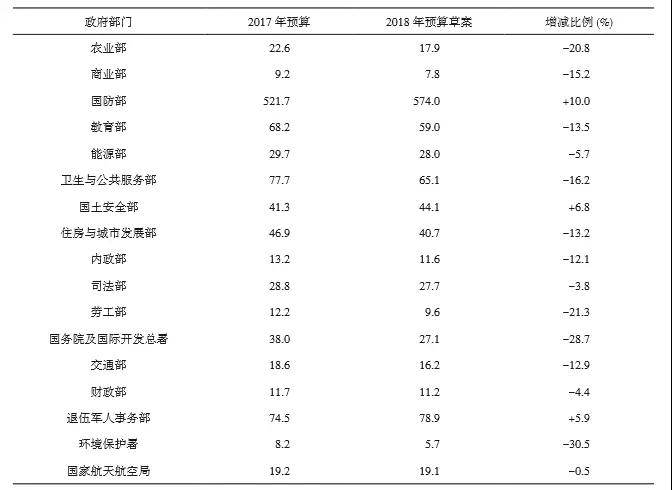

美国总统特朗普上任以来,该政府各部门预算均在缩减,除了国防部。这样的动作让各国都对美产生了戒备心,包括该国公民。

▲特朗普政府预算调配图

而在这些预算增长的过程中,有很大一笔费用被用做了现代军事武器开发。其中就包括Maven计划,此一计划应用深度学习计算机视觉技术,旨在帮助国防部门从图像和视频中提取值得注意的对象。Maven 这个单词来自于意第绪语(犹太语),意为知识的积累。而这个项目则也需要大量的知识积累才能完成。虽然国防部解释,此一计划系对无人机视频做进一步分析,可以挑选出人类目标并实施袭击。

同时有助于更好地分辨出平民,以减少无辜者被意外杀害的风险,。同时有助于更好地分辨出平民,以减少无辜者被意外杀害的风险。而前 Alphabet 董事长 Eric Schmidt 去年也在一次五角大楼会议中说:“科技圈普遍对军工联合开发武器,最终造成无辜人员伤亡这一现状怀有顾虑。”韩国KAIST大学也遭抵制而由新南威尔士大学教授Toby Walsh 发起,组织了来自全球30个国家、超过50 名人工智能和机器人研究人员,他们宣布将联合抵制韩国科学技术院大学(KAIST University),起因于KAIST在 2 月与韩国集束弹药制造商—韩华系统(Hanwha Systems)公司,设立了人工智能武器实验室,令外界担忧很可能会开发“杀手机器人”。

▲杀手机器人

Toby Walsh 表示,“KAIST的行动只会加速这场军备竞赛”,此次的学术抵制行动将在下周于日内瓦举办的联合国对于致命自主武器带来的挑战展开讨论,先前大约有 22 个国家已经呼吁彻底禁止这种武器的开发。

而被点名的KAIST 校长 Sung-Chul Shin 也随即对此做出回应,表示大学对于“人工智能”的伦理问题非常了解”,并重申 KAIST 不会进行任何对抗人类尊严的研究活动,包括不具备人类控制的自主武器。

虽然对KAIST大学的抵制意义重大,但一些专家表示,限制自动武器发展的运动是徒劳的。在此之前,已经有人工智能和机器人领域的科学家相继写信给联合国,强调在没有人为干预的情况下,杀人武器可能会破坏世界的稳定,应该受到国际条约的控制。

而这的确得到了一些国际支持,包括埃及,阿根廷和巴基斯坦在内的19个国家支持这一倡议,但也有其他国家如美国和英国等,则认为这样的作法并不切实际,因为不可能界定什么是人为控制,什么不是人为控制,当前已有许多军事系统拥有部份自主能力,包括无人机和导弹防御网络。

下一个你必须知道的新字:FAT ML

有一个关键字,不论你是不是科学家、程序员,而是每一个人都得知道,那就是 FAT ML,这是几个英文字的缩写:公平(Fairness)、责任(Accountability)、透明性(Transparency)in Machine Learning(机器学习),这股由科技界、学界发起、勿让人工智能为恶的风潮,已经从硅谷蔓延到了全球。

一直以来,科技的发展往往会带来正面和负面影响,但技术是中性的,取决于人类如何应用它,以及当有心人士利用它作恶时,有没有一套机制可以防止或挽回伤害,而人工智能也是如此,特别是AI是使用庞大的数据来进行训练,而这些训练数据能否足以代表“总体”,再加上AI的训练还是一个黑盒子,工程师们并不完全理解他们自己的算法是如何工作的,输入数据、制定条件,然后就只能等待机器出现的内容,因此很可能在无心之下,发展出具有偏见、歧视的 AI ,更何况是在意图明确的情境下发展具有 AI 能力的武器。

也就是说,开发人员在开发 AI 算法时,应该更重视算法背后的公平性、责任性、透明性,这也就是FAT ML的意义。另外,越来越多人支持,AI 发展的前提,应该是接受更多元的意见,确保社会科学家、伦理学家、哲学家、律师、医生在人工智能的开发和应用方面也应该要拥有发言权。

去年特斯拉创办人 Elon Musk 领衔全球百名AI 专家致信联合国《特定常规武器公约》会议,呼吁采取相关的措施来制止围绕“智能武器”而展开的军备竞赛。而由LinkedIn创始人 Reid Hoffman 赞助的人工智能道德及管理基金(Ethicsand Governance of Artificial Intelligence Fund)宣布向九个组织包括MIT媒体实验室、哈佛大学,提供760万美元的支持,旨在加强公民社会的声音,并协助发展符合公众利益的人工智能,还有许多重要人物像是亚马逊AWS 深度学习首席科学家AnimaAnandkumar、卡内基梅隆大学(CMU)教授Zachary Lipton、犹他大学的数据科学伦理方面的教授SureshVenkatasubramanian,也纷纷对FAT ML表达高度支持。

为什么这一群牵动全球人工智能发展的人士,会如此担心人工智能遭到恶意使用或滥用,因为这股人工智能的浪潮下,已经有不少“脱序”演出,轻则利用生成对抗式网络(GAN)打造DeepFake 换脸技术,把明星的脸套到了色情影片演员的脸上,你可能会觉得这种恶搞很有趣,但更严重的可能是将导致网路色情报复问题更加泛滥。同时,利用当今资料、数据所训练出来的人工智能也有所谓的“种族歧视”、“种族主义”问题,当然,更令人忧虑的是AI打造杀人机器,致命智能武器的潘多拉魔盒一旦打开,将很难被关上。

因此如何让人工智能是朝对整体社会有益前进,而非用以伤害人类,这将是所有人得面对的问题,值得庆幸的是,不少拥有发展AI的学者、科学家、科技人已经向全球提出了警讯。

2014年康奈尔大学信息科学系助理教授 Solon Barocas 召集了产学界成立FAT ML 年度大会,希望让世人关注逃不了的AI 道德议题,在这几年期间人工智能经历了一波盛大的高潮,我们见证了棋类游戏超越人类,人脸识别、机器翻译的水平来到了新高,机器在生活中替人类做出越来越多的决定。

但是,如何让AI符合人类良善的普世价值,无疑是AI想要走进下一个阶段必须解决的棘手问题,经典的科幻电影《2001太空漫游》(2001: ASpace Odyssey)推出至今刚满50周年,其中杀人机器人的剧情让大众感到不安忧虑,《魔鬼终结者》《机械公敌》等电影也向世人预警可能的危机,“关于人工智能,我们正在招唤恶魔。”马斯克曾如此说,那么在恶魔被召唤之前,阻止恶事发生不只是工程师、科学家的责任,而是所有人的责任。

编辑:李晨琰

责任编辑:顾军

*转载自“DeepTech深科技”