大模型带来的“智能涌现”,让人类又一次站在了技术革命的转折点。而每一次技术的演进,也都伴随着对于安全的“灵魂拷问”。大模型时代来临,安全性如何保证,成为2023世界人工智能大会期间的高频话题。

老问题在大模型时代变得特别“突出”

大模型的强大让人们瞥见了通用人工智能的曙光,但另一方面也让不少人心生忧惧。今年3月,全球就有近千名专家联名呼吁,暂停研发比GPT-4更强大的人工智能系统至少6个月,因为大模型的发展速度太快了,谁都不能忽视“硬币的另一面”。

在2023世界人工智能大会期间,不少专家就谈及它的风险,其中之一是“幻觉”的不可控性。中国科学院虚拟经济与数据科学研究中心主任、大数据挖掘与知识管理重点实验室主任石勇就曾把自己原创的诗词“投喂”给ChatGPT,ChatGPT分别回答作者是王之涣、鲁迅,这让石勇啼笑皆非:“很明显,这已经产生了知识产权的纠纷。”

复旦大学教授、上海市数据科学重点实验室主任肖仰华则谈到了隐私问题。“大模型对隐私保护问题带来了前所未有的挑战。”他认为,大模型是一个大规模参数化的模型,训练数据来源多样,让隐私保护变得困难。不仅如此,生成式大模型往往是一种“概率化”和“海量拼接式”的生产,传统意义上的隐私侵犯认定,在大模型时代往往会失效。“问题是老问题,但是在大模型时代这些问题变得特别突出。”肖仰华说。

用一种大模型来考验另一种大模型

一边是大模型带来的可信挑战,另一边,总是有行动派提前实践。

在网络安全领域常见的“红队测试”技术,就被引入大模型的安全“考试”中。“红队测试”,其实就是用一种大模型来考验另一种大模型,达到“以攻促防”的效果。在今年的人工智能大会上,清华大学就与蚂蚁集团联合发布AI安全检测平台“蚁鉴2.0”,可识别数据安全、内容安全、科技伦理三大类的数百种风险。

蚂蚁集团大安全事业群技术部总裁李俊奎向记者解释,生成式大模型是一种“深黑盒”技术,作为“红队测试”方,“蚁鉴2.0”扮演了“坏人”的角色,通过智能博弈对抗技术,模拟黑产以及自动化生成海量测试集,实现“生成式机器人”对“AIGC生成式模型”的诱导式检测计算,从而“找茬”大模型存在的弱点,反馈安全问题所在。

在大模型的赋能下,当下多个图像生成软件火速蹿红,其作画逼真程度“技惊四座”,也让生成、篡改等多形式的图片伪造门槛变得更低。有解决方法吗?合合信息在大会期间发布了一套AI图像内容安全技术方案,可精准定位截图篡改痕迹,对生成式图片进行智能判别,防止不法分子利用技术手段非法爬取图片上的信息。此外,合合还研发出AI生成图片鉴别技术,基于空域与频域关系建模,可用于判断图片是否为生成式人工智能的产物。

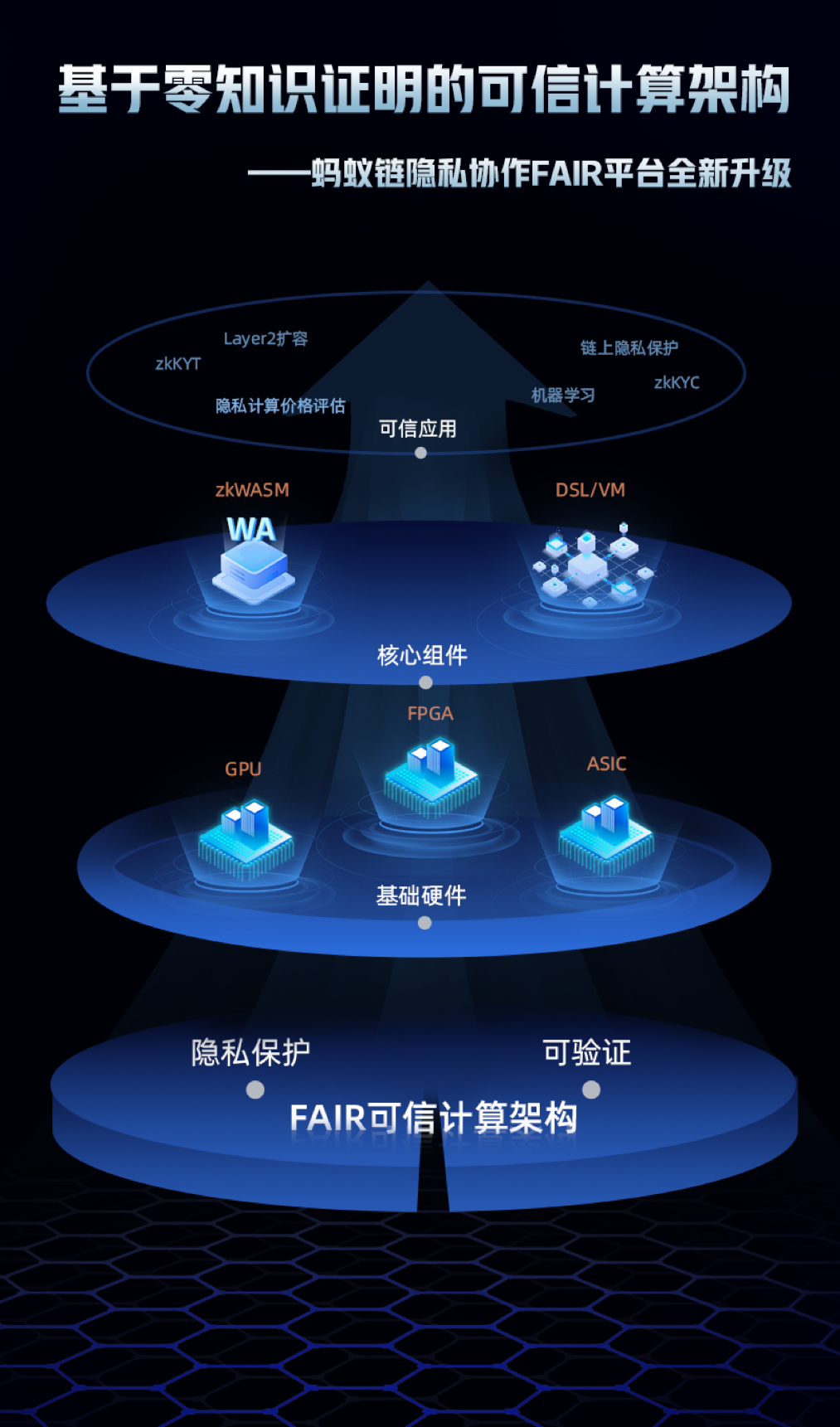

而在隐私领域,蚂蚁链宣布隐私协作平台 AntChain FAIR 进行全新架构升级,首次引入零知识证明(ZKP)为核心的可验证计算技术。蚂蚁链资深技术专家魏长征表示,零知识证明具有高效的可验证特性,再加之可以保护特定数据不被验证方看见,因此在一定程度上满足了隐私和可验证的双重需求。”

推动技术向善,让AI“德才兼备”

大模型和生成式人工智能对于各行各业的影响已近在眼前,“因噎废食”绝非良策,不少专家坦言,创造新技术和控制技术危害应同步进行。

在中国科学院院士何积丰看来,人们不能再将人工智能视为简单的技术工作,而是要作为整个组织的变革引擎,建立可信人工智能要致力于保障数据安全可信、系统行为可追责、算法模型可解释、网络环境可信、法律伦理可信。

根据中国信通院发布的《可信赖AI安全隐私技术研究》白皮书显示,目前我国在可信AI相关标准的建立方面还处于初级阶段,建议加速建立可信AI标准与监管体系、注重可信AI技术人才培养、促进可信AI热点难点问题的解决、构建可信AI安全等级评估与防御体系,构筑全产业的可信AI生态。

在世界人工智能大会期间,中国信通院、上海人工智能实验室、武汉大学、蚂蚁集团等多家单位共同发起的《AIGC可信倡议》,提出构建AIGC可信发展的全球治理合作框架,采用安全可信的数据资源、技术框架、计算方法和软件平台等,最大限度确保生成式人工智能安全、透明、可释。

著名法学家、中国法学会副会长江必新则提出“智慧法治”的概念,他认为,人工智能治理需要建立高度智慧型的法治,还需要创建创新友好型的治理。一方面,要以法治保护人工智能的知识产权,调动科创人员的积极性;另一方面,需以智能法治、智慧法治为人工智能“益智”。他还建议,要以智慧法治为人工智能“立德”,在留足创新发展空间的前提下,为人工智能设置道德高线、善行标线、伦理底线和法律红线,让人工智能“德才兼备”。

作者:徐晶卉

编辑:商慧

责任编辑:戎兵

*文汇独家稿件,转载请注明出处。